Recientemente Microsoft presentó en el evento Build2015 el servicio How Old Do I Look, una herramienta capaz calcular la edad de alguien a partir de una fotografía con la que la compañía pretende probar su nueva API de detección de rostros. El experimento ha sido un éxito, y recientemente el vicepresidente de Microsoft ha afirmado que ya se han subido 240 millones de fotos de más de 30 millones de usuarios. Hemos indagado en su funcionamiento y estos son los resultados.

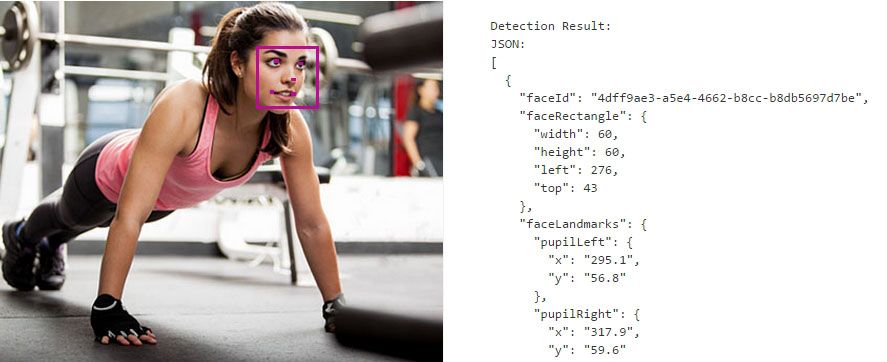

La página es capaz de detectar edad y género a partir de un curioso procedimiento de detección cuyo funcionamiento se basa en la ubicación de elementos clave del rostro. Las caras se componen de cinco puntos de control: Cada ojo, la punta de la nariz y sendas comisuras de los labios son los elementos básicos de referencia. Tras encontrar dichos puntos en la fotografía, son ubicados espacialmente con valores numéricos cartesianos y se intentan detectar otros tantos elementos de interés opcionales que dividen nuestra cara en hasta 27 marcadores. De esta forma queda registrado un perfil específico de rostro que permite, entre otras cosas, hacer que se detecte automáticamente en una fotografía la aparición de una persona determinada a partir de dichas proporciones.

Según el grado de separación de dichos puntos y por puro análisis de los estándares áureos de los rostros humanos es posible detectar los rasgos de edad y género. Evidentemente su eficiencia dependerá de la propia resolución de la imagen y el ángulo de la cámara con respecto a la fotografía (no es capaz de pillarlo de perfil), amén de determinados rostros «especialitos» de complicada detección. Por esto, es muy probable a una persona obesa se le eche menos edad por salirse de los estándares en el semblante.

A partir de aquí, la eficiencia de la herramienta dependerá de los datos almacenados en la base de conocimiento asociada al detector. Otros servicios similares utilizan una imagen de plantilla de fondo para comparar las arrugas y líneas de edad con un modelo de referencia externo. En este caso, y según las propias indicaciones de Azure y Project Oxford, el proceso es puramente analítico a partir de la geometría de los puntos de control.

Estas herramientas ya son utilizadas por un sinfín de servicios como el autoetiquetado de Facebook o la cámara de fotos dispositivos Android. Todavía no hemos llegado un grado de seguridad que nos permita utilizar nuestra cara como protección de seguridad como se ve en las películas, pero todo se andar´.

Ahaha si me salio 10 y 28 :P